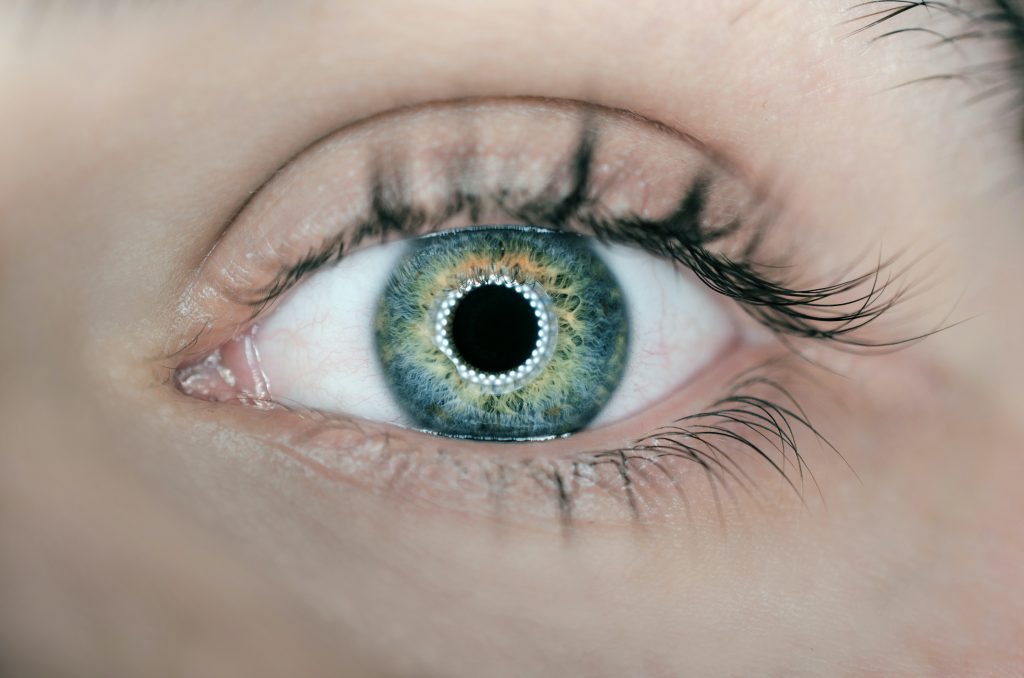

Der Graue Star, medizinisch als Katarakt bezeichnet, ist eine der häufigsten Augenerkrankungen weltweit und betrifft vor allem Menschen im fortgeschrittenen Lebensalter. Bei dieser Erkrankung trübt sich die natürliche Augenlinse zunehmend ein, was zu einer schleichenden Verschlechterung der Sehkraft führt. Betroffene beschreiben ihre Wahrnehmung oft so, als würden sie durch einen Nebel oder einen Schleier blicken. Farben erscheinen matter und weniger leuchtend, Kontraste nehmen ab, und besonders beim nächtlichen Autofahren werden Blendeffekte durch entgegenkommende Scheinwerfer als sehr störend empfunden.

Die Häufigkeit des Grauen Stars nimmt mit dem Alter deutlich zu. Während bei Menschen um die 60 Jahre etwa die Hälfte eine beginnende Linsentrübung aufweist, sind es bei den über 75-Jährigen nahezu alle, wenn auch nicht immer in einem behandlungsbedürftigen Stadium. Die Erkrankung kann jedoch auch in jüngeren Jahren auftreten, etwa durch Verletzungen, bestimmte Medikamente wie Kortison, Stoffwechselerkrankungen wie Diabetes oder angeboren sein.

Eine Grauer Star Operation wird notwendig, wenn die Sehverschlechterung den Alltag erheblich beeinträchtigt. Dies ist sehr individuell und hängt von den persönlichen Bedürfnissen und Aktivitäten ab. Während ein Mensch, der viel liest oder Auto fährt, früher eine Operation benötigt, kommt ein anderer möglicherweise länger ohne Eingriff zurecht. Sobald die Lebensqualität aber durch die eingeschränkte Sicht leidet oder Gefahrensituationen entstehen können, ist der richtige Zeitpunkt für eine Operation gekommen. Es gibt keine Medikamente oder Augentropfen, die einen Grauen Star rückgängig machen können, sodass die Operation die einzige wirksame Behandlungsmethode darstellt.

Vorbereitung auf die Operation

Der Weg zur Grauen Star Operation beginnt mit einer gründlichen augenärztlichen Untersuchung. Dabei wird nicht nur die Trübung der Linse festgestellt, sondern auch geprüft, ob andere Augenerkrankungen vorliegen, die das Operationsergebnis beeinflussen könnten. Besonders wichtig ist die Untersuchung der Netzhaut und des Sehnervs, da diese für das spätere Sehvermögen nach der Operation entscheidend sind.

Ein zentraler Schritt in der Vorbereitung ist die präzise Vermessung des Auges. Mittels moderner Verfahren wie der optischen Biometrie werden die Länge des Augapfels und die Krümmung der Hornhaut exakt bestimmt. Diese Messungen sind fundamental wichtig, denn auf ihrer Grundlage wird die Stärke der künstlichen Linse berechnet, die eingesetzt werden soll. Je präziser diese Messungen sind, desto besser kann das gewünschte Sehergebnis nach der Operation erreicht werden. Die Auswahl der Kunstlinse erfolgt in enger Absprache mit dem Operateur. Die Standardlinse, eine sogenannte Monofokallinse, ermöglicht scharfes Sehen in einer Entfernung, meist wird die Ferne eingestellt, sodass für das Lesen eine Brille benötigt wird. Für Patienten, die möglichst unabhängig von einer Brille sein möchten, stehen Premiumlinsen zur Verfügung. Multifokallinsen ermöglichen scharfes Sehen in verschiedenen Entfernungen, während torische Linsen eine bestehende Hornhautverkrümmung ausgleichen können. Jede Linsenart hat ihre spezifischen Vor- und Nachteile, über die im Aufklärungsgespräch ausführlich informiert wird. Das Aufklärungsgespräch selbst ist ein wichtiger Bestandteil der Vorbereitung. Hier werden der genaue Ablauf der Operation, mögliche Risiken und Komplikationen sowie die zu erwartenden Ergebnisse besprochen. Patienten haben die Möglichkeit, alle ihre Fragen zu stellen und sollten diese Gelegenheit auch nutzen. Erst nachdem alle Unklarheiten beseitigt sind, wird die schriftliche Einwilligung zur Operation eingeholt.

In den Tagen vor der Grauen Star Operation erhalten Patienten meist genaue Anweisungen bezüglich ihrer Medikamente. Blutverdünnende Mittel müssen eventuell pausiert oder umgestellt werden, wobei dies immer in Absprache mit dem behandelnden Arzt geschieht. Am Operationstag selbst sollte man nüchtern erscheinen, wenn eine leichte Beruhigung oder Dämmerschlaf geplant ist. Bei reiner Tropfanästhesie ist dies meist nicht erforderlich, doch auch hier gilt es, die individuellen Anweisungen der Klinik zu befolgen.

Der operative Eingriff

Der Tag der Operation beginnt meist mit einer nochmaligen Kontrolle und der Vorbereitung des Auges. Das zu operierende Auge wird mit pupillenerweiternden Tropfen behandelt, und die Augenumgebung wird desinfiziert. Patienten erhalten häufig ein leichtes Beruhigungsmittel, um Ängste zu nehmen und die Operation so angenehm wie möglich zu gestalten.

Die Operation des Grauen Stars wird mit örtlicher Betäubung durchgeführt. Dabei werden betäubende Augentropfen verabreicht, sodass der Eingriff völlig schmerzfrei ist. Manche Patienten spüren lediglich einen leichten Druck oder nehmen Lichtblitze wahr, was jedoch nicht schmerzhaft ist. In seltenen Fällen, etwa bei sehr ängstlichen Patienten oder bei bestimmten medizinischen Gründen, kann auch eine kurze Vollnarkose erwogen werden. Die standardmäßig angewandte Operationstechnik nennt sich Phakoemulsifikation. Dabei wird zunächst ein winziger, nur etwa zwei bis drei Millimeter kleiner Schnitt am Rand der Hornhaut gesetzt. Durch diese kleine Öffnung wird die vordere Kapsel der getrübten Linse eröffnet, und der Linsenkern wird mittels Ultraschall verflüssigt und abgesaugt. Dieser Vorgang erfordert höchste Präzision und wird unter dem Operationsmikroskop durchgeführt. Die hintere Linsenkapsel bleibt dabei erhalten, denn sie dient als natürliche Halterung für die künstliche Linse. Nachdem die getrübte Linse vollständig entfernt wurde, wird die zuvor ausgewählte Kunstlinse eingesetzt. Diese modernen Intraokularlinsen sind so konzipiert, dass sie gefaltet durch den kleinen Schnitt eingeführt werden können und sich im Auge selbstständig entfalten. Sie werden in der erhaltenen Linsenkapsel fixiert und bleiben dort dauerhaft an Ort und Stelle. Der winzige Schnitt am Hornhautrand ist so konstruiert, dass er sich in der Regel von selbst verschließt und nicht genäht werden muss.

Die gesamte Operation dauert üblicherweise nur 15 bis 30 Minuten pro Auge. Dank der modernen Technik und der großen Erfahrung der Operateure verläuft der Eingriff meist sehr routiniert. Dennoch bleibt es eine Operation am Auge, die höchste Konzentration und Präzision erfordert. Nach Abschluss des Eingriffs wird das operierte Auge mit einem Salbenverband geschützt, der meist schon am nächsten Tag wieder entfernt werden kann.

Nach der Operation

Die unmittelbare Zeit nach der Operation ist entscheidend für einen guten Heilungsverlauf. Direkt nach dem Eingriff können Patienten meist schon verschwommen sehen, das Auge tränt möglicherweise, und ein leichtes Fremdkörpergefühl ist normal. Am Tag nach der Operation findet die erste Nachkontrolle statt, bei der der Verband entfernt und das Auge untersucht wird. Viele Patienten sind überrascht, wie schnell sich das Sehen bereits verbessert hat, auch wenn es noch einige Tage oder Wochen dauert, bis die endgültige Sehschärfe erreicht ist.

In den ersten Tagen nach der Operation ist besondere Vorsicht geboten. Das Auge sollte nicht gerieben oder gedrückt werden, und direkter Kontakt mit Wasser ist zu vermeiden. Beim Duschen und Haarewaschen sollte darauf geachtet werden, dass kein Wasser ins operierte Auge gelangt. Schwere körperliche Arbeit, Sport und Aktivitäten, bei denen Schmutz oder Staub ins Auge gelangen könnte, sollten für mindestens zwei Wochen vermieden werden. Schwimmbad- und Saunabesuche sind ebenfalls erst nach vollständiger Abheilung wieder erlaubt. Die Nachbehandlung umfasst in der Regel die Gabe von antibiotischen und entzündungshemmenden Augentropfen. Diese müssen nach dem verordneten Schema angewendet werden, typischerweise mehrmals täglich über einen Zeitraum von mehreren Wochen. Die korrekte Anwendung dieser Tropfen ist wichtig, um Infektionen vorzubeugen und die Heilung zu fördern. Patienten erhalten genaue Anweisungen, wie die Tropfen anzuwenden sind, und sollten sich bei Unsicherheiten nicht scheuen, nachzufragen. Die Nachuntersuchungen beim Augenarzt finden üblicherweise am Tag nach der Operation, nach etwa einer Woche und nach vier bis sechs Wochen statt. Bei diesen Kontrollen wird der Heilungsverlauf überprüft, der Augeninnendruck gemessen und die Sehschärfe getestet. Sollten zwischen den Kontrollterminen plötzliche Sehverschlechterungen, starke Schmerzen oder andere ungewöhnliche Symptome auftreten, muss umgehend der Augenarzt kontaktiert werden.

Die Frage, wann normales Sehen wieder möglich ist, lässt sich nicht pauschal beantworten. Viele Patienten bemerken schon innerhalb der ersten Tage eine deutliche Verbesserung. Die endgültige Sehschärfe und die vollständige Stabilisierung des Sehvermögens stellen sich jedoch meist erst nach vier bis sechs Wochen ein. In dieser Zeit passt sich das Auge an die neue Linse an, und mögliche Schwellungen oder Reizungen klingen ab. Eine neue Brillenverordnung sollte erst nach diesem Zeitraum erfolgen, wenn das Sehergebnis stabil ist.

Chancen und Risiken

Die Kataraktoperation zählt zu den erfolgreichsten und sichersten chirurgischen Eingriffen überhaupt. Die Erfolgsquote liegt bei über 95 Prozent, und die allermeisten Patienten erleben eine deutliche Verbesserung ihrer Sehkraft und damit ihrer Lebensqualität. Farben werden wieder kräftiger wahrgenommen, Kontraste sind deutlicher, und die allgemeine Sehschärfe verbessert sich oft dramatisch. Viele Patienten berichten, dass sie erst nach der Operation bemerkt haben, wie sehr ihre Sehkraft zuvor eingeschränkt war. Dennoch handelt es sich um einen operativen Eingriff, der wie jede Operation auch Risiken birgt. Schwerwiegende Komplikationen sind äußerst selten, können aber nie vollständig ausgeschlossen werden. Zu den möglichen Komplikationen gehören Infektionen im Augeninneren, Blutungen, eine Netzhautablösung oder eine Beschädigung der Hornhaut. Das Risiko für solche ernsten Komplikationen liegt bei deutlich unter einem Prozent, dennoch müssen Patienten darüber aufgeklärt werden.

Häufiger, aber meist gut behandelbar, sind leichtere Komplikationen wie vorübergehend erhöhter Augeninnendruck, Schwellungen der Netzhautmitte oder Reste der Linsenrinde, die nachträglich entfernt werden müssen. Manche Patienten entwickeln nach der Operation vorübergehend trockene Augen, die mit befeuchtenden Tropfen behandelt werden können. Eine besondere Form der Nachbehandlung betrifft den sogenannten Nachstar oder Kapselfibrose. Dabei handelt es sich nicht um eine Komplikation im eigentlichen Sinne, sondern um eine natürliche Reaktion des Körpers. Bei etwa 20 bis 40 Prozent der operierten Patienten trübt sich die hintere Linsenkapsel, die bei der Operation als Halterung für die Kunstlinse belassen wurde, im Laufe der Monate oder Jahre nach der Operation ein. Dies führt zu einer erneuten Sehverschlechterung, die jedoch einfach und risikoarm behandelt werden kann. Mittels eines Lasers wird die getrübte Kapsel geöffnet, ein Eingriff, der nur wenige Minuten dauert, schmerzfrei ist und ambulant durchgeführt wird. Danach ist die Sicht sofort wieder klar.

Die Langzeitergebnisse nach Kataraktoperationen sind ausgesprochen gut. Die eingesetzten Kunstlinsen sind dauerhaft haltbar und müssen nicht ausgetauscht werden. Sie können nicht erneut eintrüben und bleiben ein Leben lang im Auge. Die meisten Patienten sind mit dem Ergebnis sehr zufrieden und würden die Operation jederzeit wieder durchführen lassen. Studien zeigen, dass die Lebensqualität nach erfolgreicher Kataraktoperation deutlich steigt, das Sturzrisiko sinkt und viele alltägliche Aktivitäten wieder ohne Einschränkungen möglich sind.

Besondere Aspekte

Die Wahl des richtigen Linsentyps ist eine wichtige Entscheidung, die individuell getroffen werden muss. Monofokale Standardlinsen, die von den gesetzlichen Krankenkassen vollständig übernommen werden, ermöglichen scharfes Sehen in einer Entfernung. Meist wird die Ferne scharf eingestellt, sodass für Tätigkeiten in der Nähe wie Lesen eine Brille benötigt wird. Diese Linsen liefern eine sehr gute Bildqualität und sind für die meisten Patienten eine ausgezeichnete Lösung. Multifokallinsen hingegen sind so konstruiert, dass sie mehrere Brennpunkte haben und damit theoretisch scharfes Sehen in verschiedenen Entfernungen ermöglichen sollen. Viele Patienten können nach dem Einsetzen solcher Linsen sowohl in der Ferne als auch in der Nähe ohne Brille sehen. Allerdings haben diese Linsen auch Nachteile. Manche Patienten berichten von störenden Lichteffekten wie Halos oder Blendungen, besonders beim nächtlichen Autofahren. Zudem kann die Kontrastsehschärfe etwas reduziert sein. Nicht jeder kommt mit diesen Linsen gleich gut zurecht, weshalb eine sorgfältige Beratung und realistische Erwartungen wichtig sind. Torische Linsen werden bei Patienten eingesetzt, die eine Hornhautverkrümmung haben. Diese speziellen Linsen können die Verkrümmung ausgleichen und ermöglichen so ein schärferes Sehen ohne Brille, zumindest für eine Entfernung. Sie kombinieren sozusagen die Korrektur der Katarakt mit der Korrektur der Hornhautverkrümmung in einem Eingriff.

Die Kostenfrage spielt bei der Wahl der Linse oft eine wichtige Rolle. Die gesetzlichen Krankenkassen übernehmen die Kosten für eine Standard-Kataraktoperation mit Monofokallinse vollständig. Wünscht ein Patient eine Premiumlinse wie eine Multifokal- oder torische Linse, muss er die Mehrkosten selbst tragen. Diese können je nach Linsentyp mehrere hundert bis über tausend Euro pro Auge betragen. Private Krankenkassen übernehmen in der Regel auch die Kosten für Premiumlinsen, abhängig vom individuellen Versicherungsvertrag.

Sind beide Augen vom Grauen Star betroffen, wird in der Regel zunächst nur ein Auge operiert. Nach der vollständigen Heilung und wenn das Ergebnis zufriedenstellend ist, folgt die Operation des zweiten Auges, meist nach einigen Wochen. Dieser zeitliche Abstand hat mehrere Vorteile. Zum einen kann der Patient in der Zwischenzeit mit einem Auge sehen und ist nicht vollständig in seiner Sehfähigkeit eingeschränkt. Zum anderen kann die Erfahrung aus der ersten Operation genutzt werden, um die Linsenberechnung für das zweite Auge eventuell noch zu optimieren. In bestimmten Fällen, etwa bei sehr schlechtem Sehen auf beiden Augen, kann auch eine zeitnahe Operation beider Augen erwogen werden, dies wird jedoch individuell entschieden.

Häufig gestellte Fragen betreffen unter anderem die Schmerzhaftigkeit der Operation. Wie bereits erwähnt, ist die Operation dank der örtlichen Betäubung schmerzfrei. Eine weitere häufige Frage ist, ob die Operation ambulant oder stationär durchgeführt wird. In den meisten Fällen erfolgt die Kataraktoperation ambulant, sodass der Patient noch am selben Tag nach Hause gehen kann. Nur bei bestimmten Begleiterkrankungen oder sozialen Gründen kann ein kurzer stationärer Aufenthalt sinnvoll sein. Viele Patienten fragen auch, ob sie nach der Operation wieder Auto fahren dürfen. Dies hängt vom individuellen Heilungsverlauf ab, meist ist das Autofahren nach Freigabe durch den Augenarzt und nach Erreichen der erforderlichen Sehschärfe wieder möglich, oft schon nach wenigen Tagen oder Wochen.